transformers - 🤗Transformers:用于 Pytorch、TensorFlow 和 JAX 的最先进的机器学习。

中文 |简体中文 |繁體中文 |한국어 |西班牙语 |日本語 |हिन्दी

适用于 JAX、PyTorch 和 TensorFlow 的最先进的机器学习

这些模型可应用于:

📝 文本,用于文本分类、信息提取、问答、摘要、翻译、文本生成等任务,支持 100 多种语言。🖼️ 图像,用于图像分类、对象检测和分割等任务。🗣️ 音频,用于语音识别和音频分类等任务。

转换器模型还可以组合多种模式执行任务,例如表格问答、光学字符识别、从扫描文档中提取信息、视频分类和视觉问答。

在线演示

你可以从模型中心直接在其页面上测试我们的大多数模型。我们还为公共和私有模型提供私有模型托管、版本控制和推理 API。

以下是一些示例:

在自然语言处理中:

在计算机视觉中:

- 使用 ViT 进行图像分类

- 使用 DETR 进行对象检测

- 使用SegFormer 进行语义分割

- 使用掩模成型机进行全景分割

- 使用 DPT 进行深度估算

- 使用视频MAE进行视频分类

- 使用OneFormer 进行通用分段

在音频中:

在多模式任务中:

由Hugging Face团队构建的Write With Transformer是此存储库文本生成功能的官方演示。

如果你正在寻找拥抱脸团队的定制支持

快速浏览

为了立即在给定的输入(文本、图像、音频等)上使用模型,我们提供了 API。管道将预训练模型与该模型训练期间使用的预处理组合在一起。下面介绍如何快速使用管道对正面和负面文本进行分类:

pipeline

>>> from transformers import pipeline

# Allocate a pipeline for sentiment-analysis

>>> classifier = pipeline('sentiment-analysis')

>>> classifier('We are very happy to introduce pipeline to the transformers repository.')

[{'label': 'POSITIVE', 'score': 0.9996980428695679}]第二行代码下载并缓存管道使用的预训练模型,而第三行代码根据给定文本对其进行评估。这里的答案是“肯定的”,置信度为 99.97%。

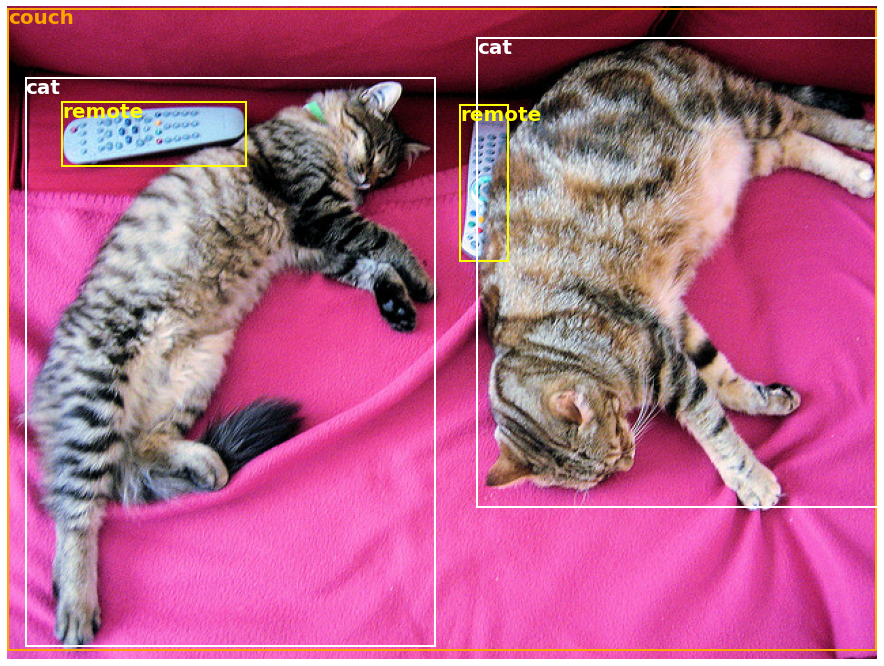

许多任务都有预先训练好的准备,在NLP中,以及在计算机视觉和语音中。例如,我们可以轻松地提取图像中检测到的对象:

pipeline

>>> import requests

>>> from PIL import Image

>>> from transformers import pipeline

# Download an image with cute cats

>>> url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

>>> image_data = requests.get(url, stream=True).raw

>>> image = Image.open(image_data)

# Allocate a pipeline for object detection

>>> object_detector = pipeline('object-detection')

>>> object_detector(image)

[{'score': 0.9982201457023621,

'label': 'remote',

'box': {'xmin': 40, 'ymin': 70, 'xmax': 175, 'ymax': 117}},

{'score': 0.9960021376609802,

'label': 'remote',

'box': {'xmin': 333, 'ymin': 72, 'xmax': 368, 'ymax': 187}},

{'score': 0.9954745173454285,

'label': 'couch',

'box': {'xmin': 0, 'ymin': 1, 'xmax': 639, 'ymax': 473}},

{'score': 0.9988006353378296,

'label': 'cat',

'box': {'xmin': 13, 'ymin': 52, 'xmax': 314, 'ymax': 470}},

{'score': 0.9986783862113953,

'label': 'cat',

'box': {'xmin': 345, 'ymin': 23, 'xmax': 640, 'ymax': 368}}]在这里,我们得到了在图像中检测到的对象列表,对象周围有一个框和一个置信度分数。这是左侧的原始图像,右侧显示预测:

你可以在本教程中了解有关 API 支持的任务的更多信息。

pipeline

除了 之外,要下载和使用给定任务中的任何预训练模型,只需三行代码。这是PyTorch版本:

pipeline

>>> from transformers import AutoTokenizer, AutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

>>> model = AutoModel.from_pretrained("bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="pt")

>>> outputs = model(**inputs)以下是TensorFlow的等效代码:

>>> from transformers import AutoTokenizer, TFAutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

>>> model = TFAutoModel.from_pretrained("bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="tf")

>>> outputs = model(**inputs)分词器负责预训练模型期望的所有预处理,可以直接在单个字符串(如上例所示)或列表上调用。它将输出一个字典,你可以在下游代码中使用,或者使用 ** 参数解包运算符直接传递给你的模型。

模型本身是一个常规的 Pytorch nn。模块或TensorFlow tf.keras.Model(取决于你的后端),你可以像往常一样使用。本教程解释了如何将这样的模型集成到经典的 PyTorch 或 TensorFlow 训练循环中,或者如何使用我们的 API 快速微调新数据集。

Trainer

为什么要使用变压器?

-

易于使用的先进型号:

- 在自然语言理解和生成、计算机视觉和音频任务方面的高性能。

- 教育工作者和从业人员的准入门槛低。

- 很少有面向用户的抽象,只有三个类需要学习。

- 用于使用我们所有预训练模型的统一 API。

-

更低的计算成本,更小的碳足迹:

- 研究人员可以共享经过训练的模型,而不是总是重新训练。

- 从业者可以减少计算时间和生产成本。

- 数十种架构,涵盖所有模态的 60,000 多个预训练模型。

-

为模型生命周期的每个部分选择正确的框架:

- 在 3 行代码中训练最先进的模型。

- 随意在TF2.0/PyTorch/JAX框架之间移动单个模型。

- 无缝选择正确的培训、评估和生产框架。

-

根据你的需求轻松定制模型或示例:

- 我们为每个架构提供了示例,以重现其原始作者发布的结果。

- 模型内部尽可能一致地公开。

- 模型文件可以独立于库使用,以进行快速实验。

为什么我不应该使用变压器?

- 该库不是神经网络构建块的模块化工具箱。模型文件中的代码不会故意使用其他抽象进行重构,因此研究人员可以快速迭代每个模型,而无需深入研究其他抽象/文件。

- 训练 API 不适用于任何模型,但经过优化以与库提供的模型配合使用。对于通用机器学习循环,应使用另一个库(可能是加速)。

- 虽然我们努力提供尽可能多的用例,但示例文件夹中的脚本只是:示例。预计它们不会在你的特定问题上开箱即用,并且你将需要更改几行代码以使它们适应你的需求。

安装

带点

该存储库在Python 3.6+,Flax 0.3.2+,PyTorch 1.3.1+和TensorFlow 2.3+上进行了测试。

你应该在虚拟环境中安装

首先,使用你将要使用的 Python 版本创建一个虚拟环境并激活它。

然后,你需要至少安装一个Flax,PyTorch或TensorFlow。请参考 TensorFlow 安装页面、PyTorch 安装页面和/或 Flax 和 Jax 安装页面,了解适用于你平台的特定安装命令。

安装其中一个后端后,

pip install transformers如果你想使用这些示例或需要代码的前沿并且迫不及待地等待新版本,则必须从源代码安装库。

与康达

从变形金刚版本 v4.0.0 开始,我们现在有一个 conda 通道:。

huggingface

conda install -c huggingface transformers按照 Flax、PyTorch 或 TensorFlow 的安装页面,了解如何使用 conda 安装它们。

注意:在 Windows 上,系统可能会提示你激活开发人员模式,以便从缓存中受益。如果这不是你的选择,请在此问题中告诉我们。

模型体系结构

Transformers 提供

- ALBERT(来自谷歌研究和芝加哥丰田技术研究所)发表了论文ALBERT:A Lite BERT for Self-supervised Learning of Language Representations,作者是Zhenzhong Lan,Mingda Chen,Sebastian Goodman,Kevin Gimpel,Piyush Sharma,Radu Soricut。

- ALIGN(来自谷歌研究院)与论文一起发布 放大视觉和视觉语言表示学习与嘈杂文本监督 由 Chao Jia、Yinfei Yang、Ye Xia、Yi-Ting Chen、Zarana Parekh、Hieu Pham、Quoc V. Le、Yunhsuan Sung、Zhen Li、Tom Duerig 撰写。

- AltCLIP(来自BAAI)与论文AltCLIP:改变CLIP中的语言编码器以进行扩展语言功能一起发布,作者是Chen,Zhongzhi和Liu,Guang和Zhang,Bo-Wen和Ye,Fulong和Yang,Qinghong和Wu,Ledell。

- Audio Spectrogram Transformer(来自 MIT )与论文AST:Audio Spectrogram Transformer一起发布,作者是Yuan Gong,Yu-An Chung,James Glass。

- BART(来自Facebook)与论文BART一起发布:自然语言生成,翻译和理解的去噪序列到序列预训练,作者是Mike Lewis,Yinhan Liu,Naman Goyal,Marjan Ghazvininejad,Abdelrahman Mohamed,Omer Levy,Ves Stoyanov和Luke Zettlemoyer。

- BARThez(来自巴黎综合理工学院)与论文BARThez:A Skilled Pretrain French Sequence-to-Sequence Model一起发布,作者是Moussa Kamal Eddine,Antoine J.-P。蒂克西尔,米哈利斯·瓦齐尔吉安尼斯。

- BARTpho(来自VinAI Research)与Nguyen Luong Tran,Duong Minh Le和Dat Quoc Nguyen的论文BARTpho:越南语的预训练序列到序列模型一起发布。

- BEiT(来自微软)与论文BEiT一起发布:图像转换器的BERT预训练,作者是Hangbo Bao,Li Dong,Furu Wei。

- BERT(来自Google)与Jacob Devlin,Ming-Wei Chang,Kenton Lee和Kristina Toutanova的论文BERT:用于语言理解的深度双向变压器的预训练一起发布。

- BERT For Sequence Generation(来自Google)与Sascha Rothe,Shashi Narayan,Aliaksei Severyn的论文Harness-Pre-train Checkpoints for Sequence Generation Tasks一起发布。

- BERTweet(来自VinAI Research)与Dat Quoc Nguyen,Thanh Vu和Anh Tuan Nguyen的论文BERTweet一起发布:英语推文的预训练语言模型。

- BigBird-Pegasus(来自谷歌研究)与Manzil Zaheer,Guru Guruganesh,Avinava Dubey,Joshua Ainslie,Chris Alberti,Santiago Ontanon,Philip Pham,Anirudh Ravula,Qifan Wang,Li Yang,Amr Ahmed的论文Big Bird:Transformers for Longer序列一起发布。

- BigBird-RoBERTa(来自谷歌研究)与Manzil Zaheer,Guru Guruganesh,Avinava Dubey,Joshua Ainslie,Chris Alberti,Santiago Ontanon,Philip Pham,Anirudh Ravula,Qifan Wang,Li Yang,Amr Ahmed的论文一起发布。

- BioGpt(来自微软研究院AI4Science)与论文BioGPT:用于生物医学文本生成和挖掘的生成预训练转换器一起发布,作者是Renqian Luo,Liai Sun,Yingce Xia,Tao Qin,Sheng Zhang,Hoifung Poon和Tie-Yan Liu。

- BiT(来自Google AI)与Alexander Kolesnikov,Lucas Beyer,Xiaohua Zhai,Joan Puigcerver,Jessica Yung,Sylvain Gelly,Neil Houlsby的论文Big Transfer(BiT):General Visual Representation学习一起发布。

- Blenderbot(来自Facebook)发布了Stephen Roller,Emily Dinan,Naman Goyal,Da Ju,Mary Williamson,Yinhan Liu,Jing Xu,Myle Ott,Kurt Shuster,Eric M. Smith,Y-Lan Boureau,Jason Weston的论文Rerecies for Build a Open Domain chatbot。

- BlenderbotSmall(来自Facebook)与Stephen Roller,Emily Dinan,Naman Goyal,Da Ju,Mary Williamson,Yinhan Liu,Jing Xu,Myle Ott,Kurt Shuster,Eric M. Smith,Y-Lan Boureau,Jason Weston的论文一起发布。

- BLIP(来自Salesforce)与论文BLIP一起发布:Bootstrapping Language-Image Pre-Training for Unified Vision-Language Understanding and Generation,作者是Junnan Li,Dongxu Li,Caim Xiong,Steven Hoi。

- BLIP-2(来自Salesforce)与论文BLIP-2:Bootstrapping Language-Image Pre-Training with Frozen Image Encoders and Large Language Models一起发布,作者是Junnan Li,Dongxu Li,Silvio Savarese,Steven Hoi。

- BLOOM(来自BigScience workshop)由BigScience Workshop发布。

- BART(来自Alexa)与Adrian de Wynter和Daniel J. Perry的论文Optimal Subarchitecture Extraction For BERT一起发布。

- BridgeTower(来自哈尔滨工业大学/微软亚洲研究院/英特尔实验室)与论文BridgeTower:在视觉语言表示学习中的编码器之间建立桥梁一起发布,作者是Xiao Xu,Chenfei Wu,Shachar Rosenman,Vasudev Lal,Wanxiang Che,Nan Duan。

- ByT5(来自Google Research)与Linting Xue,Aditya Barua,Noah Constant,Rami Al-Rfou,Sharan Narang,Mihir Kale,Adam Roberts,Colin Raffel的预训练字节到字节模型一起发布论文ByT5:迈向无令牌的未来。

- CamemBERT(来自Inria/Facebook/Sorbonne)与Louis Martin*,Benjamin Muller*,Pedro Javier Ortiz Suárez*,Yoann Dupont,Laurent Romary,Éric Villemonte de la Clergerie,Djamé Seddah和Benoît Sagot的论文CamemBERT:美味的法语模型一起发布。

- CANINE(来自Google Research)与Jonathan H. Clark,Dan Garrette,Iulia Turc,John Wieting的论文CANINE:Pre-train an Efficient Tokenization-Free Encoder for Language Representation一起发布。

- 中文-CLIP(来自OFA-Sys)与论文《中文CLIP:对比视觉语言中文预训练》一起发布,作者是杨安、潘俊舒、林俊阳、门瑞、张一昌、周静仁、周畅。

- CLAP(来自LAION-AI)与论文[大规模对比语言音频预训练与特征融合和关键字到字幕增强]https://arxiv.org/abs/2211.06687)一起发布,作者是吴玉松,陈柯,张天宇,许雨辰,泰勒伯格-柯克帕特里克,什洛莫杜布诺夫。

- CLIP(来自OpenAI)与Alec Radford,Jong Wook Kim,Chris Hallacy,Aditya Ramesh,Gabriel Goh,Sandhini Agarwal,Girish Sastry,Amanda Askell,Pamela Mishkin,Jack Clark,Gretchen Krueger,Ilya Sutskever的论文一起发布。

- CLIPSeg(来自哥廷根大学)与Timo Lüddecke和Alexander Ecker的论文《使用文本和图像提示的图像分割》一起发布。

- CodeGen(来自Salesforce)与Erik Nijkamp,Bo Pang,Hiroaki Hayashi,Lifu Tu,Huan Wang,Yingbo Zhou,Silvio Savarese,Caim Xiong的论文A Conversational Paradigm for Program Synthesis 一起发布。

- 条件DETR(来自微软亚洲研究院)与论文《快速训练收敛的条件DETR》一起发布,作者是孟德普、陈晓康、范泽佳、曾刚、李厚强、袁宇辉、孙磊、王京东。

- ConvBERT(来自依图科技)发表了论文《ConvBERT:使用基于跨度的动态卷积改进BERT》,作者是蒋子航、于伟浩、周大全、陈云鹏、冯佳石、闫水成。

- ConvNeXT(来自Facebook AI)与刘壮,毛汉子,吴超元,Christoph Feichtenhofer,Trevor Darrell,Xiining Xie的论文A ConvNet for the 2020s一起发布。

- ConvNeXTV2(来自Facebook AI)与论文ConvNeXt V2:Co-Design and Scaling ConvNets with Masked Autoencoders一起发布,作者是Sanghyun Woo,Shoubhik Debnath,Ronghang Hu,Xinlei Chen,Zhuang Liu,In So Kweon,Saining Xie。

- CPM(来自清华大学)随论文《CPM:一种大规模的生成中文预训练语言模型》一起发布,作者:张正彦、韩旭、周浩、柯培、顾玉贤、叶德明、秦玉佳、苏玉生、纪浩哲、关健、齐凡超、王晓志、郑亚南、曾国阳、曹焕琪、陈胜琪、李代轩、孙振波、刘志远、黄敏烈, 韩文涛, 唐杰, 李娟子, 朱晓燕, 孙茂松.

- CTRL(来自Salesforce)随论文CTRL:可控生成的条件转换器语言模型一起发布,作者是Nitish Shirish Keskar*,Bryan McCann*,Lav R. Varshney,Caim Xiong和Richard Socher。

- CvT(来自微软)与论文CvT一起发布:将卷积引入视觉变压器,作者是Haiping Wu,Bin Xiao,Noel Codella,Mengchen Liu,Xiyang Dai,Lu Yuan,Lei Zhang。

- Data2Vec(来自Facebook)与Alexei Baevski,Wei-Ning Hsu,Qiantong Xu,Arun Babu,Jiatao Gu,Michael Auli的论文Data2Vec一起发布:语音,视觉和语言中的自我监督学习的一般框架。

- DeBERTa(来自微软)发表了论文DeBERTa:解码增强的BERT with Disentangled Attention,作者是何鹏程,刘晓东,高剑锋,陈伟珠。

- DeBERTa-v2(来自微软)与论文DeBERTa一起发布:解码增强的BERT与解开注意力,作者是何鹏程,刘晓东,高建峰,陈伟珠。

- Decision Transformer(来自Berkeley/Facebook/Google)与Lili Chen,Kevin Lu,Aravind Rajeswaran,Kimin Lee,Aditya Grover,Michael Laskin,Pieter Abbeel,Aravind Srinivas,Igor Mordatch的论文决策转换器:通过序列建模进行强化学习一起发布。

- 可变形DETR(来自商汤研究)与论文《可变形DETR:用于端到端物体检测的可变形变压器》一起发布,作者是朱喜洲,苏伟杰,卢乐伟,李斌,王晓刚,戴继峰。

- DeiT(来自Facebook)通过Hugo Touvron,Matthieu Cord,Matthijs Douze,Francisco Massa,Alexandre Sablayrolles,Hervé Jégou的关注发布了论文Training-data-efficient image transformers & dstillation。

- DETA(来自德克萨斯大学奥斯汀分校)与Jeffrey Ouyang-Zhang,Jang Hyun Cho,Xingyi Zhou,Philipp Krähenbühl的NMS反击战一起发布。

- DETR(来自Facebook)与Nicolas Carion,Francisco Massa,Gabriel Synnaeve,Nicolas Usunier,Alexander Kirillov,Sergey Zagoruyko的T端到端对象检测一起发布。

- DialoGPT(来自微软研究院)与论文DialoGPT:对话反应生成的大规模生成预训练一起发布,作者是Yizhe Zhang,Siqi Sun,Michel Galley,Yen-Chun Chen,Chris Brockett,Xiang Gao,Jileanfeng Gao,Jingjing Liu,Bill Dolan。

- DiNAT(来自SHI Labs)与Ali Hassani和Humphrey Shi的论文Dilated Neighborhood Attention Transformer一起发布。

- DistilBERT(来自HuggingFace),与论文DistilBERT一起发布,DistilBERT是BERT的蒸馏版本:更小,更快,更便宜,更轻,由Victor Sanh,Lysandre Debut和Thomas Wolf撰写。相同的方法已被应用于将GPT2压缩为DistilGPT2,RoBERTa压缩为DistilRoBERTa,将多语言BERT压缩为DistilmBERT和德语版本的DistilBERT。

- DiT(来自微软研究院)与论文DiT一起发布:文档图像转换器的自监督预训练,作者是李俊龙,徐一恒,吕腾超,崔磊,张查,魏辅苡。

- 甜甜圈(来自NAVER),与论文一起发布的无OCR文档理解转换器由Geewook Kim,Teakgyu Hong,Moonbin Yim,Jeongyeon Nam,Jinyoung Park,Jinyeong Yim,Wonseok Hwang,Sangdoo Yun,Dongyoon Han,Seunghyun Park发布。

- DPR(来自Facebook)与Vladimir Karpukhin,Barlas Oğuz,Sewon Min,Patrick Lewis,Ledell Wu,Sergey Edunov,Danqi Chen和Wen-tau Yih的论文Dense Passage Retrieval for Open-Domain Qanswer一起发布。

- DPT(来自英特尔实验室)与René Ranftl,Alexey Bochkovskiy,Vladlen Koltun的论文一起发布。

- EfficientFormer (来自 Snap Research)随论文 EfficientFormer: Vision Transformers at MobileNetSpeed 一起发布,作者是 Yanyu Li、Geng Yuan、Yang Wen、Ju Hu、Georgios Evangelidis、Sergey Tulyakov、Yanzhi Wang、Jian Ren。

- EfficientNet(来自Google Brain)与论文EfficientNet一起发布:重新思考卷积神经网络的模型缩放,作者是Mingxing Tan,Quoc V. Le。

- ELECTRA(来自谷歌研究/斯坦福大学)与论文ELECTRA:预训练文本编码器作为鉴别器而不是生成器一起发布,作者是Kevin Clark,Minh-Thang Luong,Quoc V. Le,Christopher D. Manning。

- EncoderDecoder(来自谷歌研究)与Sascha Rothe,Shashi Narayan,Aliaksei Severyn的论文Harness-Pre-train Checkpoints for Sequence Generation Tasks一起发布。

- ERNIE(来自百度)发表了论文《ERNIE:通过知识整合增强代表性》,作者是孙宇、王硕环、李玉坤、冯世坤、陈旭义、张晗、田欣、朱丹祥、田浩、吴华。

- ErnieM(来自百度)发表了论文ERNIE-M:通过对齐跨语言语义与单语语料库来增强多语言表示,作者是Xuan Ouyang,Shuohuan Wang,Chao Pang,Yu Sun,Hao Tian,Hua Wu,Haifeng Wang。

- ESM(来自Meta AI)是变压器蛋白语言模型。ESM-1b与Alexander Rives,Joshua Meier,Tom Sercu,Siddharth Goyal,Zeming Lin,Jason Liu,Demi Guo,Myle Ott,C. Lawrence Zitnick,Jerry Ma和Rob Fergus的论文一起发布。ESM-1v与Joshua Meier,Roshan Rao,Robert Verkuil,Jason Liu,Tom Sercu和Alexander Rives的论文语言模型一起发布,能够零镜头预测突变对蛋白质功能的影响。ESM-2和ESMFold随论文一起发布 进化尺度上蛋白质序列的语言模型能够由Zeming Lin,Halil Akin,Roshan Rao,Brian Hie,Zhongkai Zhu,Wenting Lu,Allan dos Santos Costa,Maryam Fazel-Zarandi,Tom Sercu,Sal Candido,Alexander Rives进行准确的结构预测。

- FLAN-T5(来自谷歌人工智能)在存储库谷歌研究/t5x中发布,由钟亨元、侯乐、谢恩·朗普雷、巴雷特·佐夫、郑毅、威廉·费杜斯、埃里克·李、王学志、穆斯塔法·德加尼、悉达多·梵天、阿尔伯特·韦伯森、顾世祥、戴竹云、米拉克·苏兹贡、陈馨云、阿坎沙·乔杜里、夏兰·纳朗、高拉夫·米什拉、亚当斯·余、赵文森特、黄艳萍、戴安德鲁、 于洪坤、斯拉夫·彼得罗夫、埃德·奇、杰夫·迪恩、雅各布·德夫林、亚当·罗伯茨、丹尼·周、郭五乐和杰森·魏

- FLAN-UL2(来自谷歌人工智能)在存储库中发布 谷歌研究/t5x 由钟亨元、侯乐、谢恩·朗普雷、巴雷特·佐夫、郑毅、威廉·费杜斯、埃里克·李、王学志、穆斯塔法·德加尼、悉达多·梵天、阿尔伯特·韦伯森、顾世祥、戴竹云、米拉克·苏兹贡、陈馨云、阿坎沙·乔杜里、夏兰·纳朗、高拉夫·米什拉、亚当斯·余、赵文森特、黄艳萍、戴安德鲁、 于洪坤、斯拉夫·彼得罗夫、埃德·奇、杰夫·迪恩、雅各布·德夫林、亚当·罗伯茨、丹尼·周、郭五乐和杰森·魏

- FlauBERT(来自CNRS)与论文FlauBERT一起发布:法语的无监督语言模型预训练,作者是Hang Le,Loïc Vial,Jibril Frej,Vincent Segonne,Maximin Coavoux,Benjamin Lecouteux,Alexandre Allauzen,Benoît Crabbé,Laurent Besacier,Didier Schwab。

- FLAVA(来自Facebook AI)与Amanpreet Singh,Ronghang Hu,Vedanuj Goswami,Guillaume Couairon,Wojciech Galuba,Marcus Rohrbach和Douwe Kiela的论文FLAVA:基础语言和视觉对齐模型一起发布。

- FNet(来自Google Research)与James Lee-Thorp,Joshua Ainslie,Ilya Eckstein,Santiago Ontanon的论文FNet:Mixed Tokens with Fourier Transforms一起发布。

- Funnel Transformer(来自CMU / Google Brain)与论文Funnel-Transformer一起发布:过滤掉顺序冗余以实现高效的语言处理,作者是Zihang Dai,Guokun Lai,Yiming Yang,Quoc V. Le。

- GIT(来自微软研究院)与论文GIT一起发布:视觉和语言的生成图像到文本转换器,作者是王剑峰,杨正元,胡晓伟,李林杰,林凯文,甘哲,刘子成,刘策,王丽娟。

- GLPN(来自KAIST)与Doyeon Kim,Woonghyun Ga,Pyungwhan Ahn,Donggyu Joo,Sehwan Chun,Junmo Kim的论文Global-Local Path Networks for Singleeye Depth Estimation with Vertical CutDepth一起发布。

- GPT(来自OpenAI)与Alec Radford,Karthik Narasimhan,Tim Salimans和Ilya Sutskever的论文一起发布。

- GPT Neo(来自EleutherAI)由Sid Black,Stella Biderman,Leo Gao,Phil Wang和Connor Leahy在EleutherAI/gpt-neo存储库中发布。

- GPT NeoX(来自EleutherAI)与论文GPT-NeoX-20B一起发布:由Sid Black,Stella Biderman,Eric Hallahan,Quentin Anthony,Leo Gao,Laurence Golding,Horace He,Connor Leahy,Kyle McDonell,Jason Phang,Michael Pieler,USVSN Sai Prashanth,Shivanshu Purohit,Laria Reynolds,Jonathan Tow,Ben Wang,Samuel Weinbach

- GPT NeoX 日语(来自 ABEJA)由 Shinya Otani、Takayoshi Makabe、Anuj Arora 和 Kyo Hattori 发行。

- GPT-2(来自OpenAI)与Alec Radford*,Jeffrey Wu*,Rewon Child,David Luan,Dario Amodei**和Ilya Sutskever**一起发布的论文语言模型是无监督多任务学习者。

- GPT-J(来自EleutherAI)由Ben Wang和Aran Komatsuzaki在存储库kingoflolz/mesh-transformer-jax中发布。

- GPT-Sw3(来自AI-Sweden)与论文一起发布 从GPT-SW3中吸取的教训:为瑞典语构建第一个大规模生成语言模型 作者:Ariel Ekgren,Amaru Cuba Gyllensten,Evangelia Gogoulou,Alice Heiman,Severine Verlinden,Joey Öhman,Fredrik Carlsson,Magnus Sahlgren。

- GPTSAN-日语在存储库tanreinama/GPTSAN中由Toshiyuki Sakamoto(tanreinama)发布。

- Graphormer(来自微软)随论文《变形金刚真的对图表示表现不好吗?》一起发布,作者:程轩英、蔡天乐、罗胜杰、郑树新、柯国林、何迪、沈艳明、刘铁艳。

- GroupViT(来自UCSD,NVIDIA)与论文GroupViT:语义分割从文本监督中出现一起发布,作者是Jiarui Xu,Shalini De Mello,Sifei Liu,Wonmin Byeon,Thomas Breuel,Jan Kautz,Xiaolong Wang。

- 休伯特(来自Facebook)发表了一篇论文HuBERT:通过隐藏单元的掩蔽预测进行自我监督语音表示学习,作者是Wei-Ning Hsu,Benjamin Bolte,Yao-Hung Hubert Tsai,Kushal Lakhotia,Ruslan Salakhutdinov,Abdelrahman Mohamed。

- I-BERT(来自伯克利)与论文I-BERT:仅整数BERT量化一起发布,作者是Sehoon Kim,Amir Gholami,Zhewei Yao,Michael W. Mahoney,Kurt Keutzer。

- ImageGPT(来自OpenAI)与Mark Chen,Alec Radford,Rewon Child,Jeffrey Wu,Heewoo Jun,David Luan,Ilya Sutskever的论文一起发布。

- Informer(来自北京航空航天大学,加州大学伯克利分校,罗格斯大学,SEDD公司)与论文《告密者:超越长序列时间序列预测的高效变压器》一起发表,作者是周浩义,张尚航,彭杰奇,张帅,李建新,熊辉和张万才。

- 点唱机(来自OpenAI)与论文点唱机一起发布:Prafulla Dhariwal,Heewoo Jun,Christine Payne,Jong Wook Kim,Alec Radford,Ilya Sutskever的音乐生成模型。

- LayoutLM(来自微软亚洲研究院)与论文LayoutLM:文本和布局的预训练用于文档图像理解一起发布,作者是Yiheng Xu,Minhao Li,Lei Cui,Shaohan Huang,Furu Wei,Ming Zhou。

- LayoutLMv2(来自微软亚洲研究院)与论文LayoutLMv2:视觉丰富文档理解的多模态预训练一起发布,作者是Yang Xu,Yiheng Xu,Tengchao Lv,Lei Cui,Furu Wei,Guoxin Wang,Yijuan Lu,Dinei Florencio,Cha Zhang,Wanxiang Che,Min Zhang,Lidong Zhou。

- LayoutLMv3(来自微软亚洲研究院)与论文LayoutLMv3:具有统一文本和图像掩码的文档AI预训练一起发布,作者是Yupan Huang,Tengchao Lv,Lei Cui,Yutong Lu,Furu Wei。

- LayoutXLM(来自微软亚洲研究院)与论文LayoutXLM:多语言视觉丰富的文档理解的多模态预训练一起发布,作者是徐一恒,吕腾超,崔磊,王国新,卢一娟,Dinei Florencio,Cha Zhang,Furu Wei。

- LED(来自AllenAI)与Iz Beltagy,Matthew E. Peters,Arman Cohan的论文Longformer:The Long-Document Transformer一起发布。

- LeViT(来自Meta AI)与Ben Graham,Alaaeldin El-Nouby,Hugo Touvron,Pierre Stock,Armand Joulin,Hervé Jégou,Matthijs Douze的论文LeViT:ConvNet服装中的视觉转换器一起发布。

- LiLT(来自华南理工大学)发表了论文LiLT:一种简单而有效的语言独立布局转换器,用于结构化文档理解,作者是王佳鹏,金连文,丁凯。

- LLaMA(来自Meta AI的FAIR团队)发布了由Hugo Touvron,Thibaut Lavril,Gautier Izacard,Xavier Martinet,Marie-Anne Lachaux,Timothée Lacroix,Baptiste Rozière,Naman Goyal,Eric Hambro,Faisal Azhar,Aurelien Rodriguez,Armand Joulin,Edouard Grave,Guillaume Lample的论文LLaMA:开放和高效的基础语言模型。

- Longformer(来自AllenAI)与Iz Beltagy,Matthew E. Peters,Arman Cohan的论文Longformer:The Long-Document Transformer一起发布。

- LongT5(来自Google AI)与Mandy Guo,Joshua Ainslie,David Uthus,Santiago Ontanon,Jianmo Ni,Yun-Hsuan Sung,Yinfei Yang的论文LongT5:长序列的高效文本到文本转换器一起发布。

- LUKE(来自Studio Ousia)与论文LUKE一起发布:具有实体意识自我关注的深度上下文化实体表征,作者是Ikuya Yamada,Akari Asai,Hiroyuki Shindo,Hideaki Takeda,Yuji Matsumoto。

- LXMERT(来自UNC Chapel Hill)与Hao Tan和Mohit Bansal的论文LXMERT:Learning Cross-Modality Encoder Representations from Transformers for Open-Domain Qanswer一起发布。

- M-CTC-T(来自Facebook)与Loren Lugosch,Tatiana Likhomanenko,Gabriel Synnaeve和Ronan Collobert的论文Pseudo-Label For Massively Multilingual Speech Recognition一起发布。

- M2M100(来自Facebook)与Angela Fan,Shruti Bhosale,Holger Schwenk,Zhiyi Ma,Ahmed El-Kishky,Siddharth Goyal,Mandeep Baines,Onur Celebi,Guillaume Wenzek,Vishrav Chaudhary,Naman Goyal,Tom Birch,Vitaliy Liptchinsky,Sergey Edunov,Edouard Grave,Michael Auli,Armand Joulin的论文一起发布。

- 玛丽安·使用Jörg Tiedemann的OPUS数据训练的机器翻译模型。Marian 框架由 Microsoft 翻译团队开发。

- MarkupLM(来自微软亚洲研究院)与论文MarkupLM:文本和标记语言的预训练一起发布,由Junlong Li,Yiheng Xu,Lei Cui,Furu Wei发表。

- Mask2Former (来自FAIR和UIUC)与Bowen Cheng,Ishan Misra,Alexander G. Schwing,Alexander Kirillov,Rohit Girdhar的论文Masked-attention Mask Transformer for Universal Image Segmentation一起发布。

- MaskFormer (来自 Meta 和 UIUC)与 Bowen Cheng、Alexander G. Schwing、Alexander Kirillov 的论文《每像素分类不是语义分割所需的全部》一起发布。

- mBART(来自Facebook)与论文T多种语言Denoising Pre-Training for Neural Machine Translation一起发布,作者是Yinhan Liu,Jiatao Gu,Naman Goyal,Xian Li,Sergey Edunov,Marjan Ghazvininejad,Mike Lewis,Luke Zettlemoyer。

- mBART-50(来自Facebook)与论文《具有可扩展多语言预训练和微调的多语言翻译》一起发布,作者是唐玉清、周特兰、李贤、陈鹏仁、纳曼·戈亚尔、维什拉夫·乔杜里、顾嘉涛、范安吉拉。

- Megatron-BERT(来自 NVIDIA)随论文 Megatron-LM: Training Multibillion Parameter Language Models Using Model Parallelism 一起发布,作者是 Mohammad Shoeybi、Mostofa Patwary、Raul Puri、Patrick LeGresley、Jared Casper 和 Bryan Catanzaro。

- Megatron-GPT2(来自 NVIDIA)随 Mohammad Shoeybi、Mostofa Patwary、Raul Puri、Patrick LeGresley、Jared Casper 和 Bryan Catanzaro 撰写的论文《Megatron-LM:使用模型并行性训练数十亿参数语言模型》一起发布。

- MGP-STR(来自阿里巴巴研究院)发表了王鹏、程达和瑶聪的论文《场景文本识别的多粒度预测》。

- mLUKE(来自Studio Ousia)与Ryokan Ri,Ikuya Yamada和Yoshimasa Tsuruoka的论文mLUKE:多语言预训练语言模型中的实体表示的力量一起发布。

- MobileBERT(来自CMU / Google Brain)与论文MobileBERT:资源有限设备的紧凑任务无关BERT一起发布,作者是Zhiqing Sun,Hongkun Yu,Xiaodan Song,Renjie Liu,Yiming Yang和Denny Zhou。

- MobileNetV1(来自谷歌公司)与论文MobileNets一起发布:移动视觉应用的高效卷积神经网络,作者是Andrew G. Howard,Menglong Zhu,Bo Chen,Dmitry Kalenichenko,Weijun Wang,Tobias Weyand,Marco Andreetto,Hartwig Adam。

- MobileNetV2(来自Google Inc.)与Mark Sandler,Andrew Howard,Menglong Zhu,Andrey Zhmoginov,Liang-Chieh Chen的论文MobileNetV2:倒置残差和线性瓶颈一起发布。

- MobileViT(来自Apple)与Sachin Mehta和Mohammad Rastegari的论文MobileViT一起发布:轻量级,通用和移动友好的Vision Transformer。

- MPNet(来自微软研究院)与论文MPNet一起发布:语言理解的屏蔽和排列预训练,作者是宋开涛,徐谭,秦涛,卢剑锋,刘铁燕。

- MT5(来自Google AI)随论文mT5一起发布:由Linting Xue,Noah Constant,Adam Roberts,Mihir Kale,Rami Al-Rfou,Aditya Siddhant,Aditya Barua,Colin Raffel发布的大规模多语言预训练文本到文本转换器。

- MVP(来自RUC AI Box)与论文MVP:自然语言生成的多任务监督预训练一起发布,作者是唐天一,李俊毅,赵鑫和文继荣。

- NAT(来自SHI Labs)与Ali Hassani,Steven Walton,Jiachen Li,Shen Li和Humphrey Shi的论文Neighborhood Attention Transformer一起发布。

- Nezha(来自华为诺亚方舟实验室)发布了论文《NEZHA:汉语理解的神经语境化表示》,作者是魏俊秋、任晓哲、李晓光、黄文勇、廖毅、王亚生、林家舒、蒋新、陈晓和刘群。

- NLLB(来自 Meta)与 NLLB 团队的论文《No Language Left Behind: Scaling Human-Centric Machine Translation》一起发布。

- Nyströmformer(来自威斯康星大学麦迪逊分校)发表了论文Nyströmformer:一种基于Nyström的近似自我注意算法,作者是Yunyang Xiong,Zhanpeng Zeng,Rudrasis Chakraborty,Mingxing Tan,Glenn Fung,Yin Li,Vikas Singh。

- OneForformer (来自 SHI Labs)与 Jitesh Jain、Jiachen Li、MangTik Chiu、Ali Hassani、Nikita Orlov、Humphrey Shi 的论文 OneFormer: One Transformer to Rule Universal Image Segmentation 一起发布。

- OPT(来自Meta AI)与Susan Zhang,Stephen Roller,Naman Goyal,Mikel Artetxe,Moya Chen,Shuohui Chen等人的论文OPT:Open Pre-train Transformer Language Models一起发布。

- OWL-ViT(来自Google AI)与Matthias Minderer,Alexey Gritsenko,Austin Stone,Maxim Neumann,Dirk Weissenborn,Alexey Dosovitskiy,Aravindh Mahendran,Anurag Arnab,Mostafa Dehghani,Zhuoran Shen,Xiao Wang,Xiao Zhai,Thomas Kipf和Neil Houlsby的论文一起发布。

- Pegasus(来自Google)发布了论文PEGASUS:Pre-Training with Extract Gap-Sentences for Abstractive Summarization,作者是Jingqing Zhang,Yao Zhao,Mohammad Saleh和Peter J. Liu。

- PEGASUS-X(来自Google)与Jason Phang,Yao Zhao和Peter J. Liu的论文一起发布。

- Perceptionr IO(来自Deepmind)与Andrew Jaegle,Sebastian Borgeaud,Jean-Baptiste Alayrac,Carl Doersch,Catalin Ionescu,David Ding,Skanda Koppula,Daniel Zoran,Andrew Brock,Evan Shelhamer,Olivier Hénaff,Matthew M. Botvinick,Andrew Zisserman,Oriol Vinyals,João Carreira的论文Perceptionr IO:A General Architecture for Structured Inputs & Output一起发布。

- PhoBERT(来自VinAI Research)与Dat Quoc Nguyen和Anh Tuan Nguyen的论文PhoBERT一起发布:越南语预训练语言模型。

- PLBart(来自加州大学洛杉矶分校NLP)与Wasi Uddin Ahmad,Saikat Chakraborty,Baishakhi Ray,Kai-Wei Chang的论文Unified Pre-Training for Program Understanding and Generation一起发布。

- PoolForformer (来自Sea AI Labs)与论文MetaFormer 一起发布 实际上是你需要的视觉 作者是Yu,Weihao和Luo,Mi和Zhou,Pan和Si,Chenyang and Zhou,Yichen和Wang,Xinchao和Feng,Jiashi和Yan,水成。

- ProphetNet(来自微软研究院)与论文ProphetNet一起发布:预测未来的N-gram for Sequence-to-Sequence Pre-training,作者是Yu Yan,Weizhen Qi,Yeyun Gong,Dayiheng Liu,Nan Duan,Jiusheng Chen,Ruofei Zhang和Ming Zhou。

- QDQBert(来自 NVIDIA)发布了由 Hao Wu、Patrick Judd、Xiaojie Zhang、Mikhail Isaev 和 Paulius Micikevicius 撰写的论文《深度学习推理的整数量化:原理和实证评估》。

- RAG(来自Facebook)与Patrick Lewis,Ethan Perez,Aleksandara Piktus,Fabio Petroni,Vladimir Karpukhin,Naman Goyal,Heinrich Küttler,Mike Lewis,Wen-tau Yih,Tim Rocktäschel,Sebastian Riedel,Douwe Kiela的论文Retrieval-Augmented Generation for Knowledge-Intensive NLP任务一起发布。

- REALM(来自Google Research)与Kelvin Guu,Kenton Lee,Zora Tung,Panupong Pasupat和Ming-Wei Chang的论文REALM:Retrieval-Augmented Language Model Pre-training一起发布。

- 改革者(来自谷歌研究)与论文一起发布 改革者:高效的变压器 由Nikita Kitaev,Łukasz Kaiser,Anselm Levskaya撰写。

- RegNet(来自META Platforms)与Ilija Radosavovic,Raj Prateek Kosaraju,Ross Girshick,Kaim He,Piotr Dollár的论文Designing Network Design Space一起发布。

- RemBERT(来自谷歌研究)发表了一篇论文Rethinking嵌入耦合在预训练语言模型中,作者是Hyung Won Chung,Thibault Févry,Henry Tsai,M. Johnson,Sebastian Ruder。

- ResNet(来自微软研究院)发表了由何开明、张翔宇、任少清、孙健撰写的论文《用于图像识别的深度残差学习》。

- RoBERTa(来自Facebook),与论文RoBERTa一起发布:由Yinhan Liu,Myle Ott,Naman Goyal,Jingfei Du,Mandar Joshi,Danqi Chen,Omer Levy,Mike Lewis,Luke Zettlemoyer,Veselin Stoyanov。

- RoBERTa-PreLayerNorm(来自Facebook)与Myle Ott,Sergey Edunov,Alexei Baevski,Angela Fan,Sam Gross,Nathan Ng,David Grangier,Michael Auli的论文fairseq一起发布:序列建模的快速,可扩展工具包。

- RoCBert(来自微信AI)与HuiSu,Weiweishi,XiaoyuShen,XiaoZhou,TuoJi,JiaruiFang,周杰的论文RoCBert一起发布:具有多模态对比预训练的鲁棒中文伯特。

- RoFormer(来自ZhuiyiTechnology),与论文RoFormer一起发布:具有旋转位置嵌入的增强型变压器,由苏健林和卢宇以及潘胜峰和Bo Wen和刘云峰发布。

- SegForformer (来自 NVIDIA)随论文 SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers 一起发布,作者是 Enze Xie、Wenhai Wang、Zhiding Yu、Anima Anandkumar、Jose M. Alvarez、Ping Luo。

- SEW(来自ASAPP)与Felix Wu,Kwangyoun Kim,Jing Pan,Kyu Han,Kilian Q. Weinberger,Yoav Artzi的论文Performance-Efficiency Trade-offs in Unsupervised Pre-Training for Speech Recognition一起发布。

- SEW-D(来自ASAPP)与Felix Wu,Kwangyoun Kim,Jing Pan,Kyu Han,Kilian Q. Weinberger,Yoav Artzi的论文Performance-Efficiency Trade-offs in Unsupervised Pre-Training for Speech Recognition一起发布。

- SpeechT5(来自微软研究院)与论文SpeechT5:统一模态编码器-解码器口语处理的预训练一起发布,作者是欧俊义,王睿,周龙,王成一,任硕,吴宇,刘树杰,汤姆·高,李青,张宇,魏志华,姚倩,李金宇,魏辅苐。

- SpeechToTextTransformer(来自Facebook),与论文fairseq S2T:快速语音到文本建模一起发布,由Changhan Wang,Yun Tang,Xutai Ma,Anne Wu,Dmytro Okhonko,Juan Pino发布。

- SpeechToTextTransformer2(来自Facebook),与Chang-Scale Self-and Semi-Supervised Learning for Speech Translation的论文一起发布,作者是Changhan Wang,Anne Wu,Juan Pino,Alexei Baevski,Michael Auli,Alexis Conneau。

- Splinter(来自特拉维夫大学),与Ori Ram,Yuval Kirstain,Jonathan Berant,Amir Globerson,Omer Levy的论文Few-Shot问答一起发布。

- SqueezeBERT(来自伯克利)与论文SqueezeBERT一起发布:计算机视觉可以教NLP关于高效神经网络的什么?作者:Forrest N. Iandola,Albert E. Shaw,Ravi Krishna和Kurt W. Keutzer。

- Swin Transformer(来自微软)与论文Swin Transformer:使用Shift Windows的分层视觉变压器一起发布,作者是刘泽,林宇彤,曹悦,胡涵,魏一轩,张铮,Stephen Lin,郭柏宁。

- Swin Transformer V2(来自微软)与论文Swin Transformer V2:扩展容量和分辨率一起发布,作者是刘泽,胡晗,林宇彤,姚竹良,谢振达,魏一轩,贾宁,曹跃,张铮,董丽,魏芙蓉,郭柏宁。

- Swin2SR(来自维尔茨堡大学)与论文Swin2SR:SwinV2变压器用于压缩图像超分辨率和恢复一起发布,作者Marcos V. Conde,Ui-Jin Choi,Maxime Burchi,Radu Timofte。

- SwitchTransformers(来自Google)与William Fedus,Barret Zoph,Noam Shazeer的论文Switch Transformers:Scaling to Trillion Parameter Models with Simple and Efficient Sparsity一起发布。

- T5(来自Google AI)与Colin Raffel和Noam Shazeer以及Adam Roberts和Katherine Lee以及Sharan Narang和Michael Matena和Yanqi Zhou以及Wei Li和Peter J. Liu的论文一起发布。

- T5v1.1(来自Google AI)由Colin Raffel和Noam Shazeer和Adam Roberts和Katherine Lee和Sharan Narang和Michael Matena和Yanqi Zhou以及Wei Li和Peter J. Liu在存储库google-research/text-to-text-transfer-transformer中发布。

- Table Transformer(来自微软研究院)与Brandon Smock,Rohith Pesala,Robin Abraham的论文PubTables-1M:Towards Comprehensive Table Extraction from Unstructured Documents一起发布。

- TAPAS(来自Google AI)与Jonathan Herzig,Paweł Krzysztof Nowak,Thomas Müller,Francesco Piccinno和Julian Martin Eisenschlos的论文TAPAS:通过预训练的弱监督表解析一起发布。

- TAPEX(来自微软研究院)与论文TAPEX:通过学习神经SQL执行器进行表预训练一起发布,作者是Qian Liu,Bei Chen,Jiaqi Guo,Morteza Ziyadi,Zeqi Lin,Weizhu Chen,Jian-Guang Lou。

- 时间序列转换器(来自HuggingFace)。

- TimeSformer (来自 Facebook)随论文一起发布 时空注意力只是你需要视频理解吗?由 Gedas Bertasius、Heng Wang、Lorenzo Torresani 撰写。

- Trajectory Transformer(来自加州大学伯克利分校)与Michael Janner,Qiyang Li,Sergey Levine的论文Offline Reinforcement Learning as One Big Sequence Modeling一起发布

- Transformer-XL(来自Google/CMU)与论文Transformer-XL:超越固定长度上下文的注意力语言模型一起发布,作者是Zihang Dai*,Zhilin Yang*,Yiming Yang,Jaime Carbonell,Quoc V. Le,Ruslan Salakhutdinov。

- TrOCR(来自微软),与论文TrOCR:基于变压器的光学字符识别与预训练模型一起发布,作者是李明浩,吕腾超,崔磊,卢一娟,Dinei Florencio,Cha Zhang,Zhoujun Li,Furu Wei。

- TVLT(来自UNC Chapel Hill)与论文TVLT一起发布:无文本视觉语言转换器,作者是Zineng Tang,Jaemin Cho,Yixin Nie,Mohit Bansal。

- UL2(来自谷歌研究)与Yi Tay,Mostafa Dehghani,Vinh Q. Tran,Xavier Garcia,Dara Bahri,Tal Schuster,Huaixiu Steven Zheng,Neil Houlsby,Donald Metzler的论文Unizing Language Learning Paradigms一起发布

- UniSpeech(来自微软研究院)与论文UniSpeech一起发布:使用标记和未标记数据进行统一语音表示学习,作者是王成义,吴宇,姚钱,熊谷健一,刘树杰,魏傅,Michael Zeng,黄学东。

- UniSpeechSat(来自微软研究院)与论文 UNISPEECH-SAT: UNIVERSAL SPEECH REPRESENTATIONLEARNING WITH SPEAKER AWARE PRE-TRAINING 一起发布,作者是陈三元、吴宇、王成一、陈正扬、陈卓、刘树杰、吴健、姚倩、魏辅苚、李金宇、于祥展。

- UPerNet(来自北京大学)发表了论文《场景理解的统一感知解析》,作者是肖泰特、刘英成、周博磊、蒋宇宁、孙健。

- VAN(来自清华大学和南开大学)发表了由郭孟浩、卢成泽、刘正宁、程明明、胡世敏发表的论文《视觉注意力网络》。

- VideoMAE(来自南京大学多媒体计算组)与论文VideoMAE:掩蔽自动编码器是用于自监督视频预训练的数据高效学习者一起发布,作者是Zhan Tong,Yibing Song,Jue Wang,Limin Wang。

- ViLT(来自NAVER AI Lab/Kakao Enterprise/Kakao Brain)与论文ViLT:没有卷积或区域监督的视觉和语言转换器一起发布,作者是Wonjae Kim,Bokyung Son,Ildoo Kim。

- 视觉转换器(ViT)(来自Google AI)与论文一起发布 图像价值16x16 Words:Transformers for Image Recognition at Scale 作者:Alexey Dosovitskiy,Lucas Beyer,Alexander Kolesnikov,Dirk Weissenborn,Xiaohua Zhai,Thomas Unterthiner,Mostafa Dehghani,Matthias Minderer,Georg Heigold,Sylvain Gelly,Jakob Uszkoreit,Neil Houlsby。

- VisualBERT(来自加州大学洛杉矶分校NLP)与论文VisualBERT:视觉和语言的简单和性能基线一起发布,作者是Liunian Harold Li,Mark Yatskar,Da Yin,Cho-Jui Hsieh,Kai-Wei Chang。

- ViT Hybrid(来自Google AI)随论文一起发布 图像价值16x16个单词:Transformers for Image Recognition at Scale 作者:Alexey Dosovitskiy,Lucas Beyer,Alexander Kolesnikov,Dirk Weissenborn,Xiaohua Zhai,Thomas Unterthiner,Mostafa Dehghani,Matthias Minderer,Georg Heigold,Sylvain Gelly,Jakob Uszkoreit,Neil Houlsby。

- ViTMAE(来自Meta AI)与论文一起发布 蒙面自动编码器是可扩展的视觉学习者 作者是何凯明,陈新磊,谢赛宁,李阳浩,Piotr Dollár,Ross Girshick。

- ViTMSN(来自Meta AI)与Mahmoud Assran,Mathilde Caron,Ishan Misra,Piotr Bojanowski,Florian Bordes,Pascal Vincent,Armand Joulin,Michael Rabbat,Nicolas Ballas的论文一起发布。

- Wav2Vec2(来自Facebook AI)与Alexei Baevski,Henry Zhou,Abdelrahman Mohamed,Michael Auli的论文wav2vec 2.0:语音表示的自监督学习框架一起发布。

- Wav2Vec2-Conformer(来自Facebook AI)与论文FAIRSEQ S2T:快速语音到文本建模与FAIRSEQ一起发布,作者是Changhan Wang,Yun Tang,Xutai Ma,Anne Wu,Sravya Popuri,Dmytro Okhonko,Juan Pino。

- Wav2Vec2Phoneme(来自Facebook AI)与由Qiantong Xu,Alexei Baevski,Michael Auli发表的论文Simple and Effective Zero-shot-Cross-lingual Scaleme Recognition一起发布。

- WavLM(来自微软研究院)发表了论文WavLM:全栈语音处理的大规模自监督预训练,作者是陈三元、王成义、陈正扬、吴宇、刘淑杰、陈卓、李金宇、神田直之、吉冈拓哉、肖熊、吴健、周龙、任硕、钱彦民、姚倩、吴健、曾邱、魏魏。

- Whisper(来自OpenAI)与Alec Radford,Jong Wook Kim,Tao Xu,Greg Brockman,Christine McLeavey,Ilya Sutskever的论文一起发布。

- X-CLIP(来自微软研究院)与论文《扩展语言图像预训练模型用于通用视频识别》一起发布,作者是倪博林、彭厚文、陈明昊、张松阳、孟高峰、傅建龙、向世明、凌海滨。

- X-MOD(来自Meta AI)与Jonas Pfeiffer,Naman Goyal,Xi Lin,Xian Li,James Cross,Sebastian Riedel,Mikel Artetxe的论文一起发布。

- XGLM(来自Facebook AI)与论文一起发布 使用多语言模型进行少镜头学习 作者:Xi Victoria Lin,Todor Mihaylov,Mikel Artetxe,Tianlu Wang,Shuohi Chen,Daniel Simig,Myle Ott,Naman Goyal,Shruti Bhosale,Jingfei Du,Ramakanth Pasunuru,Sam Shleifer,Punit Singh Koura,Vishrav Chaudhary,Brian O'Horo,Jeff Wang,Luke Zettlemoyer,Zornitsa Kozareva,Mona Diab,Veselin Stoyanov, 李贤.

- XLM(来自Facebook)与Guillaume Langple和Alexis Conneau的论文《跨语言语言模型预训练》一起发布。

- XLM-ProphetNet(来自微软研究院)与论文ProphetNet一起发布:预测未来的N-gram for Sequence-to-Sequence Pre-training,作者是Yu Yan,Weizhen Qi,Yeyun Gong,Dayiheng Liu,Nan Duan,Jiusheng Chen,Ruofei Zhang和Ming Zhou。

- XLM-RoBERTa(来自Facebook AI),与Alexis Conneau*,Kartikay Khandelwal*,Naman Goyal,Vishrav Chaudhary,Guillaume Wenzek,Francisco Guzmán,Edouard Grave,Myle Ott,Luke Zettlemoyer和Veselin Stoyanov的论文一起发布。

- XLM-RoBERTa-XL(来自Facebook AI),与Naman Goyal,Jingfei Du,Myle Ott,Giri Anantharaman,Alexis Conneau的论文Larger-Scale Transformers for T多种语言蒙版语言建模一起发布。

- XLM-V(来自Meta AI)与Davis Liang,Hila Gonen,MaoYuning Mao,Rui Hou,Naman Goyal,Marjan Ghazvininejad,Luke Zettlemoyer,Madian Khabsa的论文XLM-V:克服多语言掩蔽语言模型中的词汇瓶颈一起发布。

- XLNet(来自Google/CMU)与论文XLNet一起发布:广义自回归预训练语言理解,作者是Zhilin Yang*,Zihang Dai*,Yiming Yang,Jaime Carbonell,Ruslan Salakhutdinov,Quoc V. Le。

- XLS-R(来自Facebook AI)与论文XLS-R一起发布:自监督跨语言语音表示大规模学习,作者是Arun Babu,Changhan Wang,Andros Tjandra,Kushal Lakhotia,Qiantong Xu,Naman Goyal,Kritika Singh,Patrick von Platen,Yatharth Saraf,Juan Pino,Alexei Baevski,Alexis Conneau,Michael Auli。

- XLSR-Wav2Vec2(来自Facebook AI)与Alexis Conneau,Alexei Baevski,Ronan Collobert,Abdelrahman Mohamed,Michael Auli的论文一起发布。

- YOLOS(来自华中科技大学)发表了论文《你只看一个序列:通过物体检测重新思考视觉中的变压器》,作者是方宇新、廖本成、王兴刚、方杰民、齐继阳、吴睿、牛建伟、刘文宇。

- YOSO(来自威斯康星大学麦迪逊分校)与论文一起发布 你只采样(几乎)一次:线性成本自我关注通过伯努利抽样 Zhanpeng Zeng,熊云阳,Sathya N. Ravi,Shailesh Acharya,Glenn Fung,Vikas Singh。

- 想贡献一个新模型吗?我们添加了详细的指南和模板,以指导你添加新模型的过程。你可以在存储库的

模板文件夹中找到它们。在开始 PR 之前,请务必检查贡献指南并联系维护者或打开问题以收集反馈。

要检查每个模型是否在 Flax、PyTorch 或 TensorFlow 中都有实现,或者是否有由 Tokenizers 库支持的

这些实现已在多个数据集上进行了测试(请参阅示例脚本),并且应与原始实现的性能相匹配。你可以在文档的示例部分找到有关性能的更多详细信息。

了解更多信息

| 部分 | 描述 |

|---|---|

| 文档 | 完整的 API 文档和教程 |

| 任务摘要 | 变压器支持 |

| 预处理教程 | 使用该类为模型准备数据Tokenizer |

| 培训和微调 | 在 PyTorch/TensorFlow 训练循环中使用 Transformers 提供的Trainer |

| 快速浏览:微调/使用脚本 | 用于在各种任务上微调模型的示例脚本 |

| 模型共享和上传 | 上传并与社区共享你的微调模型 |

| 迁移 | 从或迁移到pytorch-transformers pytorch-pretrained-bert |

引文

我们现在有一篇论文,你可以为变形金刚图书馆引用

@inproceedings{wolf-etal-2020-transformers,

title = "Transformers: State-of-the-Art Natural Language Processing",

author = "Thomas Wolf and Lysandre Debut and Victor Sanh and Julien Chaumond and Clement Delangue and Anthony Moi and Pierric Cistac and Tim Rault and Rémi Louf and Morgan Funtowicz and Joe Davison and Sam Shleifer and Patrick von Platen and Clara Ma and Yacine Jernite and Julien Plu and Canwen Xu and Teven Le Scao and Sylvain Gugger and Mariama Drame and Quentin Lhoest and Alexander M. Rush",

booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

month = oct,

year = "2020",

address = "Online",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2020.emnlp-demos.6",

pages = "38--45"

}