Luotuo-Chinese-LLM - 中文的微调指令 LLaMA

Camel (罗陀):中国羊驼

Camel (罗驼)是 Camel 的汉语拼音(发音)

中文微调教学LLaMA。由冷子昂 @ 商汤科技, 陈启源 @ 华中师范大学(本科三年级学生)和李鲁鲁 @ 商汤科技开发

(电子邮件:chengli@sensetime.com、zaleng@bu.edu、chenqiyuan1012@foxmail.com)

这不是商汤科技的官方产品

我们将项目命名为 Camel ( Camel ),因为LLaMA和羊驼都属于偶蹄目- Camel 科(偶蹄目- Camel 科)

新闻

[2023-3-25] 罗拖-1.0正在训练中!感谢所有赞助商!

[2023-3-25] 驼铃,在基于中文模型GLM上调整中文数据,现已成为个人回购。我们也可以将原来的罗拓移到新的仓库中。

[2023-3-24] 我们刚刚发布了驼铃(驼铃):通过 LoRA 在 GLM-6B 上用很少的数据调整中文 LLM,试试这里 ,我们可能会很快创建一个新的存储库

快速入门

| 科拉布链接 | 细节 | |

|---|---|---|

| Camel 铃快速评估 | 拓陵具体评估代码 | |

| 快速评估 | 具有标准拥抱面管道的评估代码 | |

| 带接口的机器人 | 使用Gradio的交互式聊天机器人 | |

| 训练代码 | 待发布 | 训练代码,在 colab 上运行 |

| 数据转换 | 将羊驼.json翻译成中文 |

训练模型

| 型号名称 | 训练数据和设置 |

|---|---|

| 罗陀-罗拉-7b-0.1 | 接受翻译后的羊驼 52k 数据训练 |

| 罗陀-洛拉-7b-0.3 | 接受翻译羊驼 52k 数据 + 瓜纳科,1 个纪元的训练 |

| 罗陀-罗拉-7b-0.9 | (计划中)清洁羊驼52k +完整的瓜纳科 |

罗拓-lora-7b-0.3 性能似乎比 0.1 有显着提高, 即使在 1 纪元之后.

但是 1 个纪元花费了我们 7 个小时的训练时间,花费了 10 多美元。我们稍后会继续调整它。

定性结果(0.3)

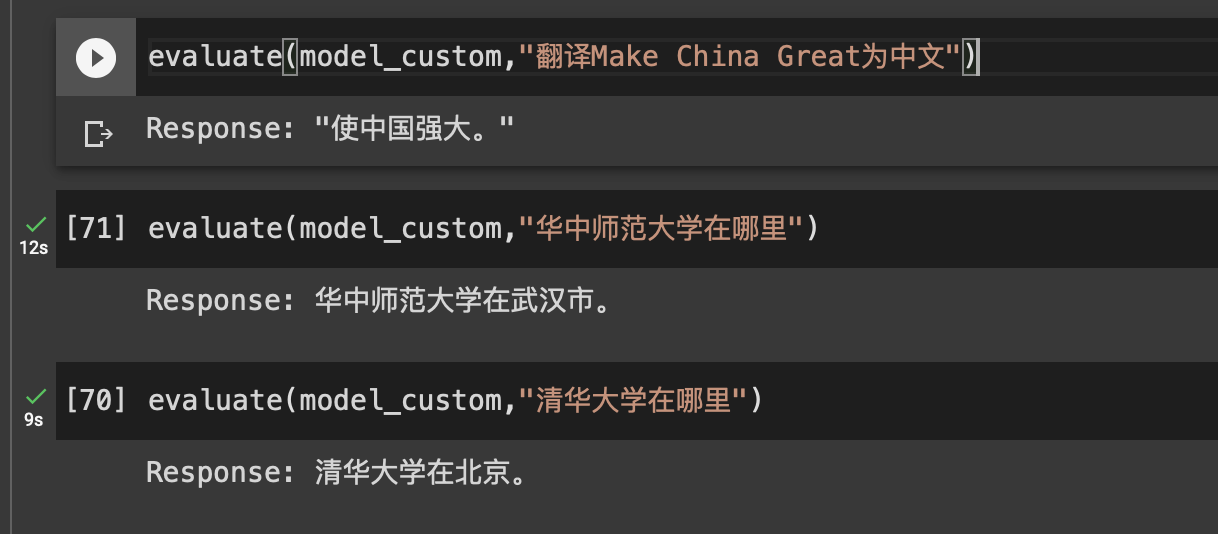

评估代码现在位于notebook/evaluation_code.ipynb 中

好例子

Input: 中国的首都在哪里? Luotuo-Output: 中国的首都是北京。

Input: 麦当劳是哪个国家的? Luotuo-Output: 美国。

Input: 2017年美国总统是谁 Luotuo-Output: 2017年美国总统是特朗普

Input: 华中师范大学在哪里 Luotuo-0.1-Output: 华中师范大学位于北京 Luotuo-0.3-Output: 华中师范大学在武汉市。

此示例在 0.1 中失败

不好的例子

Input: 商汤科技是做什么的? Luotuo-0.1-Output: 商汤科技是一种技术,它用于创建互联网应用程序和服务。 Luotuo-0.3-Output: 商汤科技是一种技术,它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的产品和服务,以增加产品和服务的吸引力。它可以用于创建新的

Input: 猫和狗的关系是什么 Luotuo-Output: 猫和狗之间的关系是友好的。它们通常在一起休息或玩耍。猫和狗之间的关系通常很好,它们通常在一起休息或玩耍。猫和狗之间的关系通常很好,它们通常在一起休息或玩耍。猫和狗之间的关系通常很好,它们通常在一起休息或玩耍。猫和狗之间的关系通常很好,它们通常在一起休息或玩耍。猫和狗之间的关系通常很好,它们通常在一起休息或玩耍。猫和狗之间的关系通常

训练

我们已经调整了一个中国LLaMA模型,基于LLaMA, 斯坦福羊驼, 羊驼LoRA, cabrita, 日本羊驼 - LoRA

训练代码在清理中,如果你很着急,检查日语项目,只需更改json训练数据文件名即可。

数据

这是一个建筑项目

训练代码仅在日本羊驼LoRA上进行了轻微更改

A. 0.1版本模型在翻译数据上进行训练,使用ChatGPT API将alpaca_data.json翻译成中文。我们花了大约30-45美元将完整的数据集翻译成中文。提供翻译后的数据。(trans_chinese_alpaca_data.json)

B.我们还计划考虑Guanaco hikariming的alpaca_chinese_dataset和carbonz0的羊驼-中国数据集中的数据,可能会将其更新到以后的版本。

我们计划上传两种不同的模型A和B,因为B的提供者声称干净的数据将带来显着的改进。

赞助(赞助)

前三大赞助商

| 时间 | 发起人 | 量 |

|---|---|---|

| 2023/3/25 | 肖** | 520 |

| 2023/3/24 | 伊普勒 | 512 |

| 2023/3/24 | 希君 | 500 |

| 2023/3/24 | 倪** | 500 |

余额 = 2374 现在。详细余额见 sponsorship_and_balance.md

这原本是我们的一个作业项目,我们原本计划训练到1.0为止。但是社区的热情超过了我们的想象。如果你愿意赞助我们的项目,可以

扫描这个二维码

并且加这个支付宝账号,留下你的姓名

项目的资金流向将被公开,所有的资金将被用于数据的标注,训练算力的购买或者后续周边产品的发放。数据和算力的捐献也会一同总结在赞助的表格中。备用链接 二维码 , 支付宝账号

这原本是我们的一个锻炼项目,我们原本计划训练到 1.0 版本。然而,社区的热情超出了我们的预期。如果你愿意赞助我们的项目,你可以扫描此二维码并添加此支付宝帐户,留下你的名字。

所有资金将用于数据标注、购买训练算力或后续周边产品的分销。

待办事项并成为贡献者

看来,基础版完成后还有很多后续任务要做。社区中的许多开发人员提出了更友好的建议,我在 TODO_list.md 中放置了一个更长的 TODO 列表。

建筑内项目

- [X] 将羊驼 JSON 数据翻译成中文

- [X] 使用 lora 进行微调(模型 0.1)

- [X] 0.1 版模型(型号 A)

- [X] 模型到拥抱脸,GUI 演示

- [X] 用更多的羊驼数据训练劳拉(模型 0.3)

- [ ] (处理中)用更多羊驼数据训练 lora(模型 0.9)

我们计划使用这个罗拓项目作为整个中文LLM项目的git存储库。原《罗陀:LLaMA-LoRA》完成后,将迁移到洛陀- Vanilla 。 Camel 铃、楼兰、丝绸之路等衍生汉语示范项目将逐步加入罗陀项目。

引文

如果使用此存储库中的数据或代码,请引用存储库。

@misc{alpaca,

author={Ziang Leng, Qiyuan Chen and Cheng Li},

title = {Luotuo: An Instruction-following Chinese Language, LoRA tuning on LLaMA model},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {\url{https://github.com/LC1332/Chinese-alpaca-lora}},

}