sam-hq - 我们提出 HQ-SAM 来升级 SAM 以实现高质量的零样本分割。

高质量地分割任何内容

细分任何高品质的

雷科,叶明桥,马丁丹内尔扬,刘一凡,戴宇荣,唐志强,费舍尔 苏黎世

联邦理工学院和香港科技大学

我们建议 HQ-SAM 升级 SAM 以实现高质量的零镜头分割。有关更多详细信息,请参阅我们的论文。我们的代码和模型将在两周内发布。敬请期待!

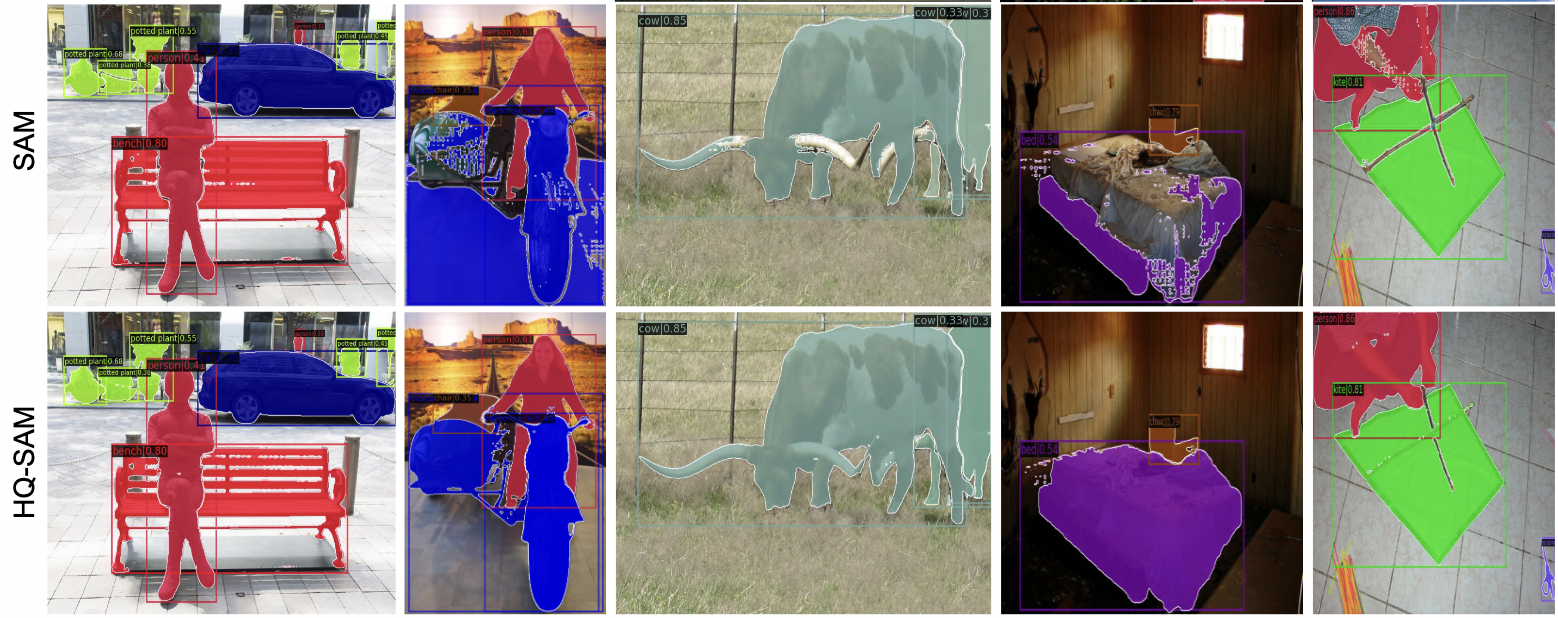

SAM 和 HQ-SAM 之间的视觉比较

山姆 vs. 总部-山姆

|

|

|

|

|

|

介绍

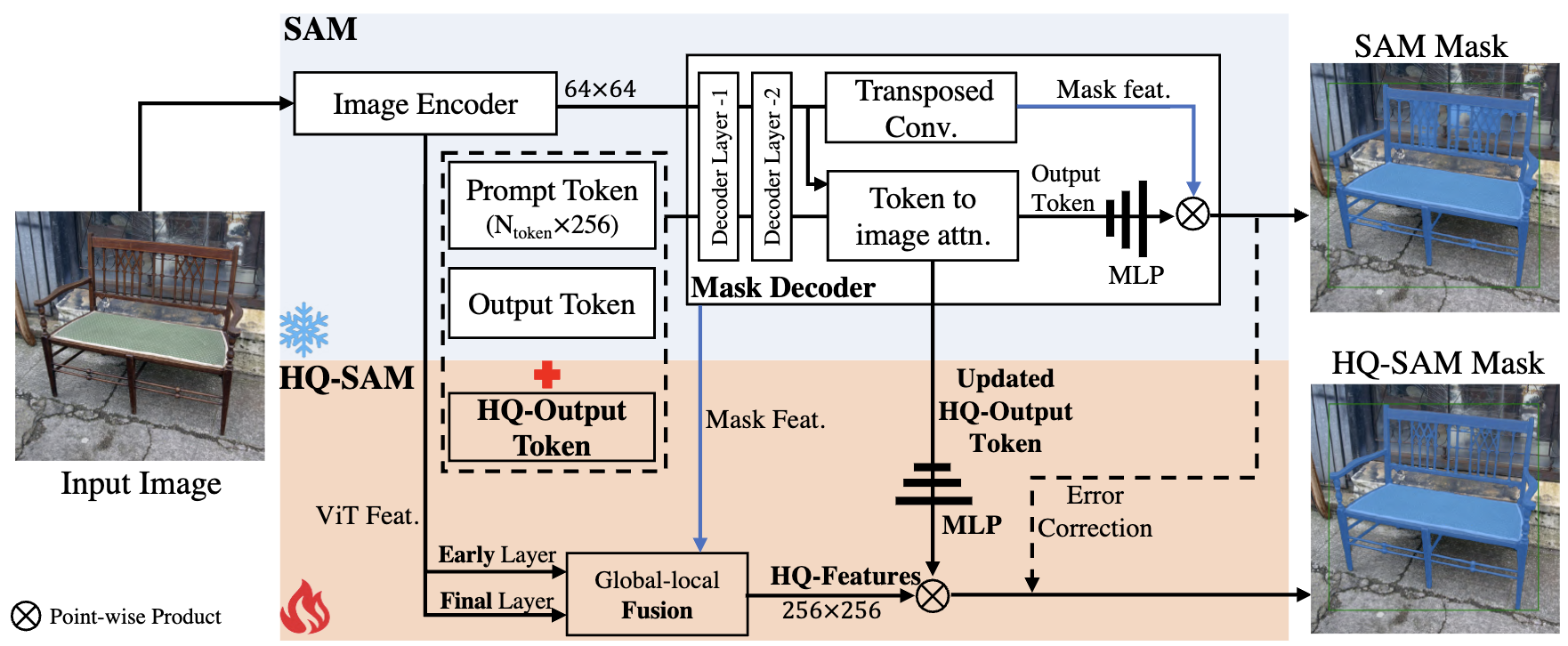

最近的细分任何模型 (SAM) 代表了扩展分割模型的一大飞跃,允许强大的零镜头功能和灵活的提示。尽管经过 11 亿个面罩的训练,SAM 的掩模预测质量在许多情况下都不足,尤其是在处理具有复杂结构的物体时。我们提出了HQ-SAM,使SAM能够准确分割任何物体,同时保持SAM原始的可提示设计,效率和零镜头泛化性。我们精心的设计重用并保留了 SAM 的预训练模型权重,同时只引入了最少的额外参数和计算。我们设计了一个可学习的高质量输出令牌,将其注入SAM的掩码解码器中,并负责预测高质量的掩码。我们不仅将其应用于掩模解码器功能,还首先将它们与早期和最终的ViT功能融合在一起,以改善掩模细节。为了训练我们引入的可学习参数,我们从多个来源组成了一个包含 44K 细粒度掩码的数据集。HQ-SAM 仅在引入的 44k 掩码集上进行训练,这在 8 个 GPU 上只需要 4 小时。我们在一套包含 9 个不同分割数据集的套件中展示了 HQ-SAM 在不同下游任务中的功效,其中 7 个数据集在零样本传输协议中进行评估。

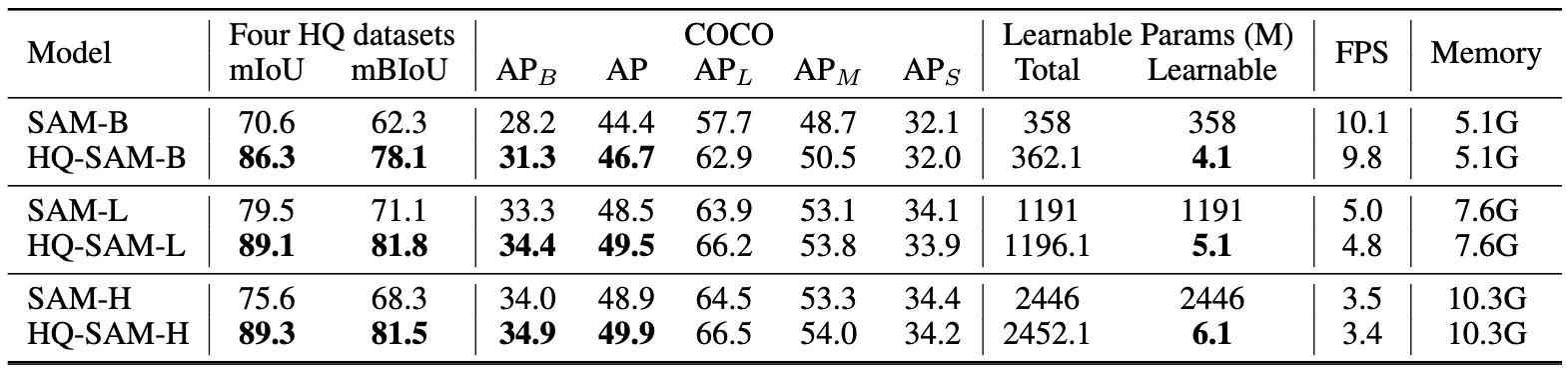

SAM和HQ-SAM之间的定量比较

注意:对于基于框提示的评估,我们向SAM和我们的HQ-SAM提供相同的图像/视频边界框,并采用SAM的单掩码输出模式。

COCO 上的各种 ViT 主干网:

注意:对于COCO数据集,我们使用在COCO数据集上训练的SOTA检测器FocalNet-DINO作为我们的框提示生成器。

注意:对于COCO数据集,我们使用在COCO数据集上训练的SOTA检测器FocalNet-DINO作为我们的框提示生成器。

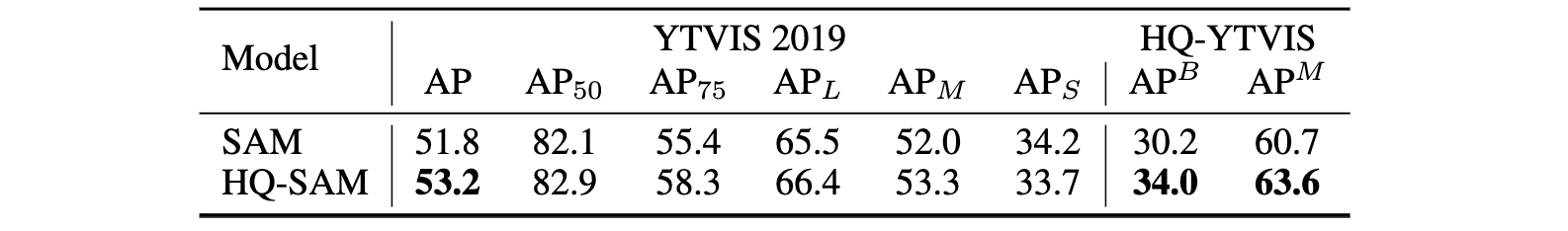

YTVIS 和 HQ-YTVIS

注意:使用 ViT-L 主干网。我们采用在YouTubeVIS 2019数据集上训练的SOTA检测器Mask2Former 作为我们的视频盒提示生成器,同时重用其对象关联预测。

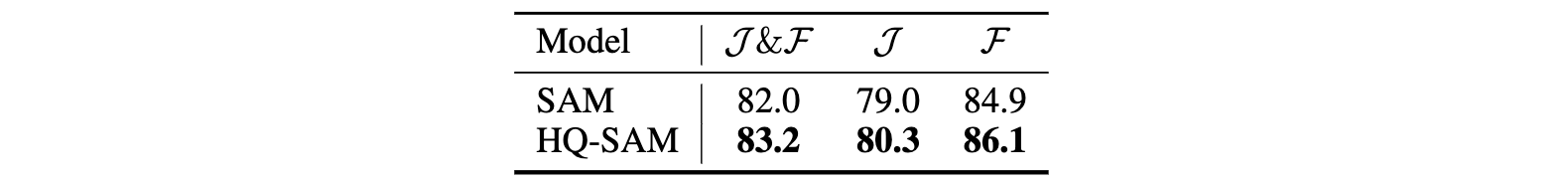

戴维斯

注意:使用 ViT-L 主干网。我们采用SOTA模型XMem作为我们的视频盒提示生成器,同时重用其对象关联预测。

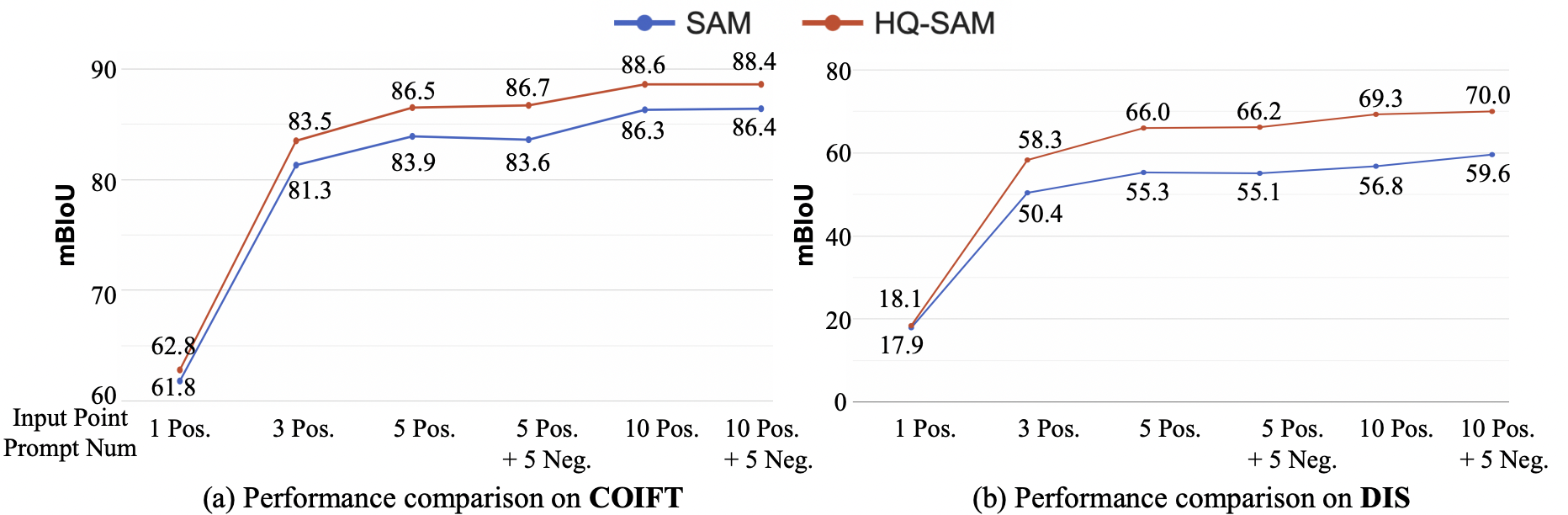

使用各种点进行交互式细分比较

注意:使用 ViT-L 主干网。在高质量的COIFT(零射)和DIS值集上。

引文

如果你发现 HQ-SAM 在你的研究中有用或参考提供的基线结果,请为该存储库加星标

@article{sam_hq,

title={Segment Anything in High Quality},

author={Ke, Lei and Ye, Mingqiao and Danelljan, Martin and Liu, Yifan and Tai, Yu-Wing and Tang, Chi-Keung and Yu, Fisher},

journal = {arXiv:2306.01567},

year = {2023}

}

确认

- 感谢 SAM 的公共代码和发布的模型。